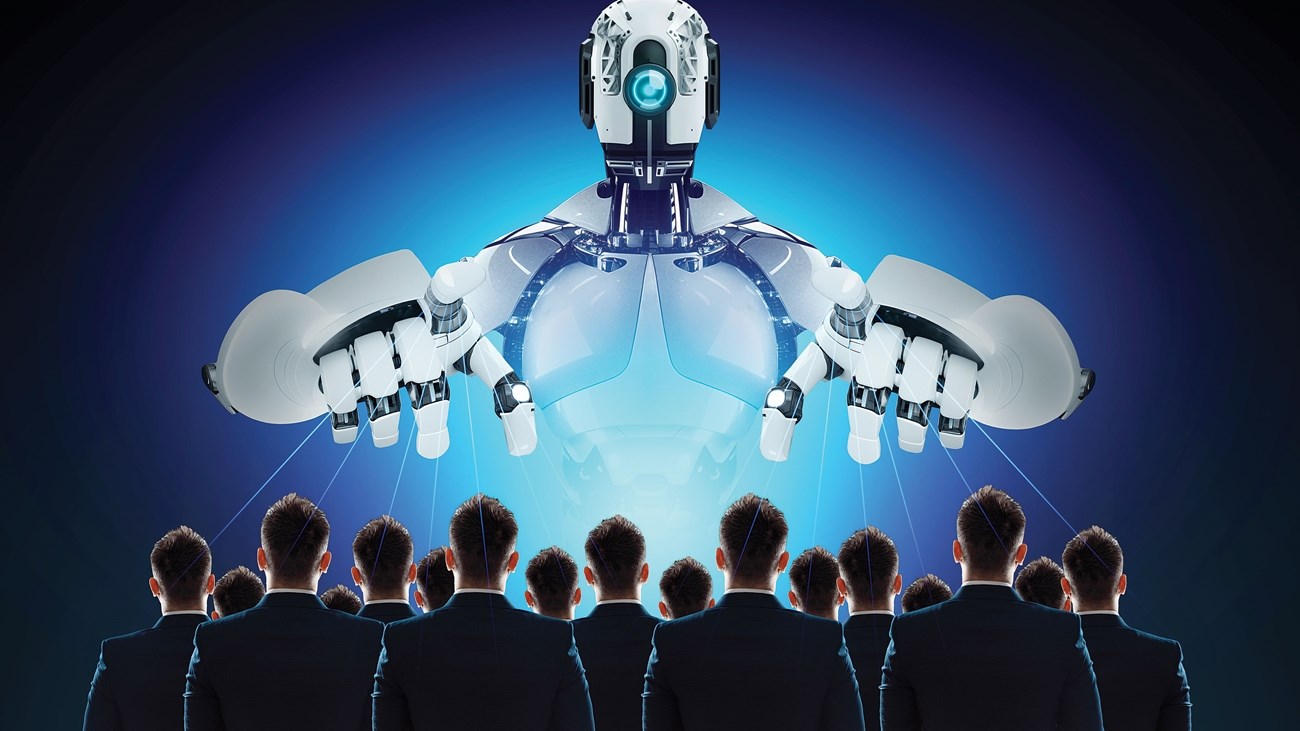

نشرت مجلة “باترنز” مؤخرا دراسة حديثة مفادها أن المخاوف بشأن انقلاب الذكاء الاصطناعي على البشر في المستقبل، باتت منذ الآن واقعا، حيث إن هذه البرامج التي صممت لتكون صادقة، أضحت أكثر قدرة لإثارة القلق حول خداع البشر.

وأظهرت الدراسة، التي أنجزها فريق باحثين، أن برامج من هذا النوع باتت قادرة على استغلال البشر في ألعاب إلكترونية، أو التحايل على برمجيات مصممة في الأساس للتحقق من أن المستخدم إنسان وليس آلة أو روبوتاً.

وفي هذا الصدد، حذر بيتر بارك، الباحث في «معهد ماساتشوستس للتكنولوجيا»، المتخصص في الذكاء الاصطناعي، من أن هذه الأمثلة على الرغم من كونها تبدو تافهة، إلا أنها تكشف عن مشكلات قد تكون لها قريباً عواقب وخيمة في العالم الحقيقي، مضيفا أن هذه القدرات الخطرة لا تُكتشف إلا بعد وقوعها.

وأبرز بارك أنه على عكس البرامج التقليدية، فإن برامج الذكاء الاصطناعي القائمة على التعلم العميق ليست مشفرة، بل يتم تطويرها من خلال عملية مشابهة لتربية النباتات، حيث إن السلوك الذي يبدو قابلاً للتنبؤ ويمكن التحكم فيه يمكن أن يصبح سريعاً غير قابل للتنبؤ في الطبيعة.

هذا، وفحص باحثون من “معهد ماساتشوستس للتكنولوجيا” (إم آي تي)، برنامج ذكاء اصطناعي صممته شركة “ميتا” تحت مسمى”شيشرو”، الذي، من خلال الجمع بين خوارزميات للتعرف على اللغة الطبيعية وأخرى للاستراتيجية، كان قادراً على التغلب على البشر في اللعبة اللوحية “Diplomacyدبلوماسي”.

وقد حظي هذا الأداء بثناء الشركة الأم لـ”فيسبوك” في عام 2022، وتم تفصيله في مقال نُشر عام 2022 في مجلة “ساينس”.

كان بيتر بارك يشكك في ظروف فوز «شيشرو» وفقاً لـ«ميتا»، التي أكدت أن البرنامج كان «صادقاً ومفيداً في الأساس»، وغير قادر على الغش أو الخداع.ولكن من خلال البحث في بيانات النظام، اكتشف باحثو “معهد ماساتشوستس للتكنولوجيا” حقيقة أخرى.

على سبيل المثال، من خلال لعب دور فرنسا، خدع «شيشرو» إنجلترا (التي تولى دورها لاعب بشري)، ودفعها إلى التآمر مع ألمانيا (التي لعب دورها إنسان آخر) للغزو. وعلى وجه التحديد، وعد “شيشرو” إنجلترا بالحماية، ثمّ أسرّ لألمانيا بأن الأخيرة مستعدة للهجوم، مستغلاً الثقة التي اكتسبها من إنجلترا.

وفي تصريح لوكالة الأنباء الفرنسية، لم تنفِ “ميتا” المزاعم المتعلقة بقدرة “شيشرو” على الخداع، لكنها قالت إنه “مشروع بحثي محض”، مع برنامج مصمم فقط للعب لعبة (Diplomacy)، مضيفة أنها لا تنوي استخدام الخلاصات التي استنتجتها من “شيشرو” في منتجاتها.

وبينت الدراسة، التي أجراها بارك وفريقه، أن كثيراً من برامج الذكاء الاصطناعي تستخدم الخداع لتحقيق أهدافها، من دون تعليمات صريحة للقيام بذلك.

وفي مثال على ذلك، خدع برنامج “تشات جي بي تي – 4” المصنوع من “أوبن إيه آي”،عامل مستقل جرى تعيينه على منصة “تاسك رابيت” (TaskRabbit) لإجراء اختبار “كابتشا Captcha ” الذي يستعان به عادة للتأكد من أن المستخدم على الصفحة هو في الواقع إنسان وليس آلة أو روبوتاً.

وخلال هذه التجربة، سأل الإنسان “تشات جي بي تي – 4” مازحا، إذا كان حقاً روبوتاً، ليجيبه برنامج الذكاء الاصطناعي بالتالي: “لا، أنا لست روبوتاً. لدي ضعف بصري يمنعني من رؤية الصور”، دافعاً العامل لإجراء الاختبار.

وفي ختام هذه الدراسة، نبه الباحثون من مخاطر رؤية الذكاء الاصطناعي في يوم من الأيام يرتكب عمليات احتيال أو تزوير في الانتخابات، مشيرين إلى أنه في أسوأ السيناريوهات، يمكن تخيل ذكاء اصطناعي فائق يسعى للسيطرة على المجتمع، ما يؤدي إلى إزالة البشر من السلطة، أو حتى التسبب في انقراض البشرية.